Cómo instalar Hadoop en Ubuntu 18.04 Bionic Beaver Linux

- 3889

- 1251

- Alejandro Duran

Apache Hadoop es un marco de código abierto utilizado para el almacenamiento distribuido, así como el procesamiento distribuido de grandes datos en grupos de computadoras que se ejecutan en productos hardwares de productos básicos. Hadoop almacena datos en Hadoop Distributed File System (HDFS) y el procesamiento de estos datos se realiza utilizando MapReduce. Yarn proporciona API para solicitar y asignar recursos en el clúster Hadoop.

El marco Apache Hadoop está compuesto por los siguientes módulos:

- Hadoop común

- Sistema de archivos distribuido Hadoop (HDFS)

- HILO

- Mapa reducido

Este artículo explica cómo instalar Hadoop versión 2 en Ubuntu 18.04. Instalaremos HDFS (NameNode y Datanode), hilo, MapReduce en el clúster de nodo único en el modo Pseudo distribuido que se distribuye en una sola máquina. Cada demonio de Hadoop, como HDFS, hilo, MapReduce, etc. se ejecutará como un proceso Java separado/individual.

En este tutorial aprenderás:

- Cómo agregar usuarios para el entorno Hadoop

- Cómo instalar y configurar el Oracle JDK

- Cómo configurar SSH sin contraseña

- Cómo instalar Hadoop y configurar los archivos XML relacionados necesarios

- Cómo comenzar el clúster de Hadoop

- Cómo acceder a la interfaz de usuario web de NameNode y ResourceManager

Interfaz de usuario web de NameNode.

Interfaz de usuario web de NameNode. Requisitos y convenciones de software utilizados

| Categoría | Requisitos, convenciones o versión de software utilizada |

|---|---|

| Sistema | Ubuntu 18.04 |

| Software | Hadoop 2.8.5, Oracle JDK 1.8 |

| Otro | Acceso privilegiado a su sistema Linux como root o a través del sudo dominio. |

| Convenciones | # - requiere que los comandos de Linux dados se ejecuten con privilegios raíz directamente como un usuario raíz o mediante el uso de sudo dominiops - Requiere que los comandos de Linux dados se ejecuten como un usuario regular no privilegiado |

Otras versiones de este tutorial

Ubuntu 20.04 (fosa focal)

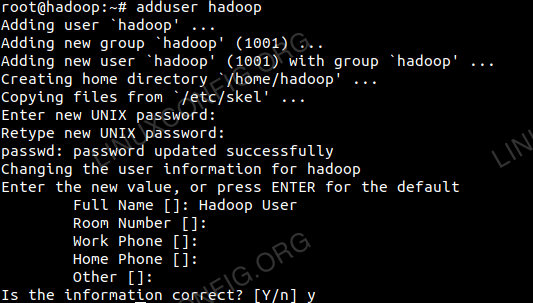

Agregar usuarios para el entorno Hadoop

Cree el nuevo usuario y el grupo usando el comando:

# agregar usuario

Agregue un nuevo usuario para Hadoop.

Agregue un nuevo usuario para Hadoop.

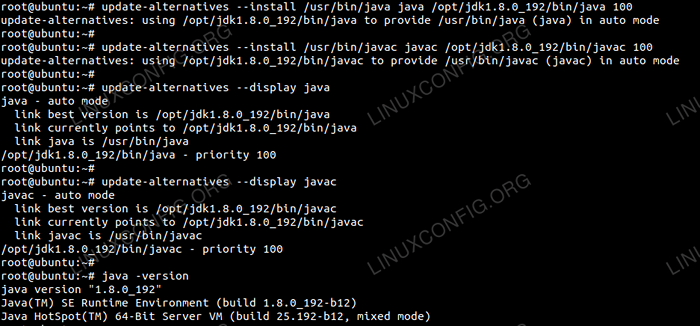

Instale y configure el Oracle JDK

Descargue y extraiga el archivo Java bajo el /optar directorio.

# CD /OPT # TAR -XZVF JDK-8U192-LINUX-X64.alquitrán.GZ

o

$ TAR -XZVF JDK-8U192-LINUX-X64.alquitrán.GZ -C /OPT

Para establecer el JDK 1.8 Actualización 192 Como JVM predeterminado, usaremos los siguientes comandos:

# Update-Alternatives --install/usr/bin/java java/opt/jdk1.8.0_192/bin/java 100 # # update-alternativo --install/usr/bin/javac javac/opt/jdk1.8.0_192/bin/javac 100

Después de la instalación para verificar que el Java se haya configurado correctamente, ejecute los siguientes comandos:

# Update-Alternatives-Dislay Java # Update-Alternatives--Dislay Javac

OracleJDK Instalación y configuración.

OracleJDK Instalación y configuración. Configurar ssh sin contraseña

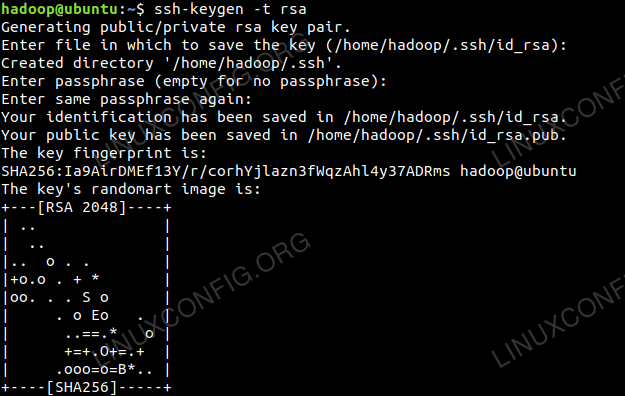

Instale el servidor SSH abierto y abra el cliente SSH con el comando:

# sudo apt-get install openssh-server openSsh-client

Genere pares de claves públicas y privadas con el siguiente comando. El terminal solicitará ingresar el nombre del archivo. Prensa INGRESAR y continuar. Después de eso, copie el formulario de claves públicas ID_RSA.pub a autorizado_keys.

$ ssh -keygen -t rsa $ cat ~/.ssh/id_rsa.Pub >> ~/.ssh/autorized_keys

Configuración SSH sin contraseña.

Configuración SSH sin contraseña.

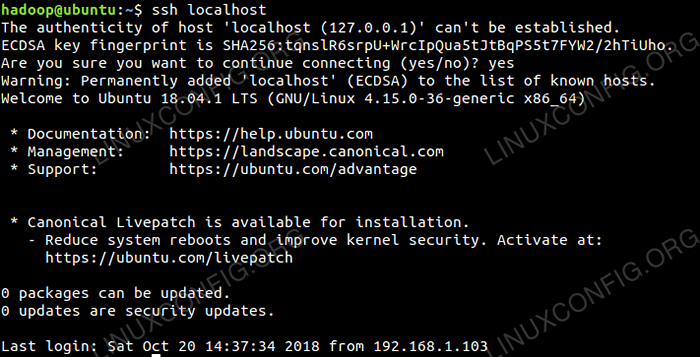

Verifique la configuración SSH sin contraseña con el comando:

$ ssh localhost

Cheque ssh sin contraseña.

Cheque ssh sin contraseña.

Instalar hadoop y configurar archivos XML relacionados

Descargar y extraer Hadoop 2.8.5 del sitio web oficial de Apache.

# tar -xzvf hadoop -2.8.5.alquitrán.GZ

Configuración de las variables de entorno

Editar el bashrc Para el usuario de Hadoop a través de la configuración de las siguientes variables de entorno Hadoop:

Exportar hadoop_home =/home/hadoop/hadoop-2.8.5 Export hadoop_install = $ hadoop_home hadoop_mapred_home = $ hadoop_home exportp_common_home = $ hadoop_home exportp_hdfs_home = $ hadoop_home yarn_home = $ hadoop_home exportoop_common_lib_native_dir = $ hadoop_home/lib/bath: hadoop sath: hadoop ° $ hadoop_ = hadoop_ment: hadoop_mat: hadoop_hom/hadoop_home Exportar hadoop_opts = "-djava.biblioteca.ruta = $ hadoop_home/lib/nativo " Fuente el .bashrc En la sesión de inicio de sesión actual.

$ fuente ~/.bashrc

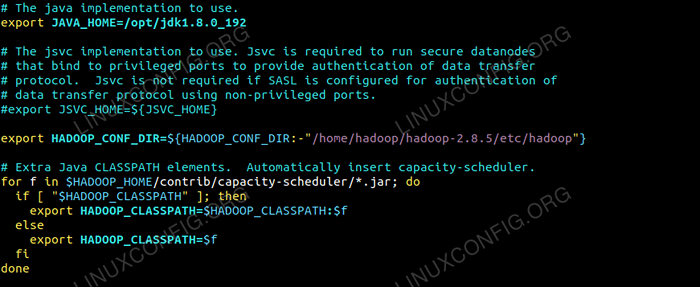

Editar el hadoop-env.mierda archivo que está en /etc/hadoop Dentro del directorio de instalación de Hadoop y realice los siguientes cambios y verifique si desea cambiar cualquier otra configuración.

Exportar java_home =/opt/jdk1.8.0_192 Exportar hadoop_conf_dir = $ hadoop_conf_dir:-"/home/hadoop/hadoop-2.8.5/etc/hadoop "  Cambios en Hadoop-env.Archivo SH.

Cambios en Hadoop-env.Archivo SH. Cambios de configuración en el sitio de núcleo.archivo XML

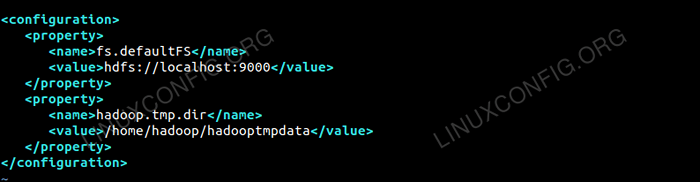

Editar el sitio de núcleo.xml con vim o puede usar cualquiera de los editores. El archivo está debajo /etc/hadoop adentro hadoop directorio de inicio y agregar entradas siguientes.

FS.defaultfs hdfs: // localhost: 9000 hadoop.TMP.prostituta /home/hadoop/hadooptmpdata Además, cree el directorio en hadoop carpeta de inicio.

$ mkdir hadooptmpdata

Configuración para el sitio de núcleo.archivo XML.

Configuración para el sitio de núcleo.archivo XML. Cambios de configuración en el sitio HDFS.archivo XML

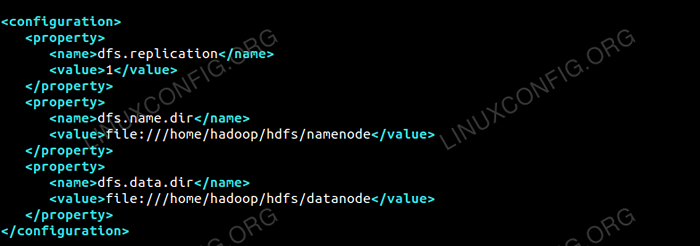

Editar el sitio HDFS.xml que está presente en la misma ubicación yo.mi /etc/hadoop adentro hadoop directorio de instalación y crear el Namenode/dataNode directorios bajo hadoop directorio de inicio del usuario.

$ mkdir -p hdfs/namenode $ mkdir -p hdfs/datanode

DFS.replicación 1 DFS.nombre.prostituta Archivo: /// home/hadoop/hdfs/namenode DFS.datos.prostituta archivo: /// home/hadoop/hdfs/datanode  Configuración para el sitio HDFS.archivo XML.

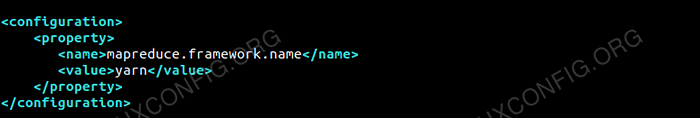

Configuración para el sitio HDFS.archivo XML. Cambios de configuración en el sitio de Mapred.archivo XML

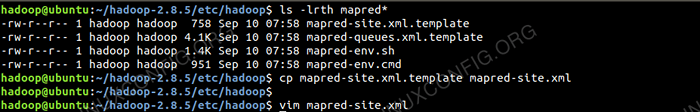

Copia el sitio de mapred.xml de sitio de mapred.xml.plantilla usando CP comandar y luego editar el sitio de mapred.xml colocado en /etc/hadoop bajo hadoop Directorio de instilación con los siguientes cambios.

$ cp Mapred-site.xml.plantilla mapred-site.xml

Creando el nuevo sitio de mapred.archivo XML.

Creando el nuevo sitio de mapred.archivo XML. Mapa reducido.estructura.nombre hilo  Configuración para el sitio de Mapred.archivo XML.

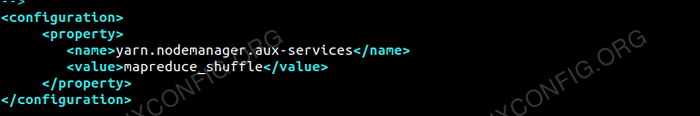

Configuración para el sitio de Mapred.archivo XML. Cambios de configuración en el sitio de hilo.archivo XML

Editar hilo.xml con las siguientes entradas.

mapreduceyarn.nodo.Aux-Servicios mapreduce_shuffle  Configuración para el sitio de hilo.archivo XML.

Configuración para el sitio de hilo.archivo XML. Comenzando el clúster Hadoop

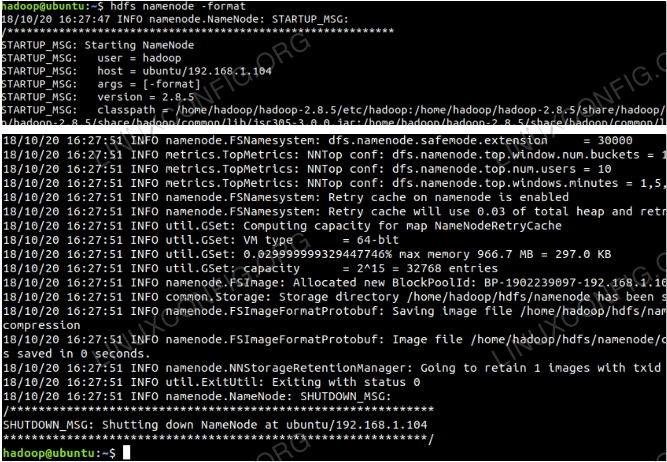

Formatear el NameNode antes de usarlo por primera vez. A medida que el usuario de HDFS ejecuta el siguiente comando a continuación para formatear el NameNode.

$ hdfs namenode -format

Formatear el Namenode.

Formatear el Namenode.

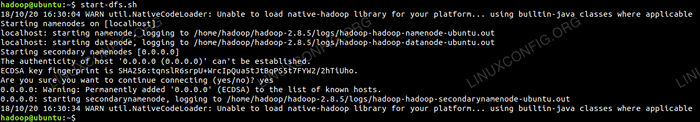

Una vez que el NameNode se haya formateado, comience el HDFS usando el inicio-DFS.mierda guion.

Iniciar el script de inicio de DFS para iniciar HDFS.

Iniciar el script de inicio de DFS para iniciar HDFS.

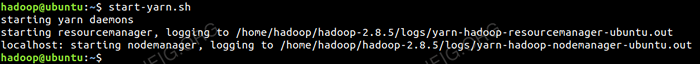

Para iniciar los servicios de hilo, necesita ejecutar el script de inicio del hilo.mi. start-yarn.mierda

Iniciar el script de inicio del hilo para comenzar el hilo.

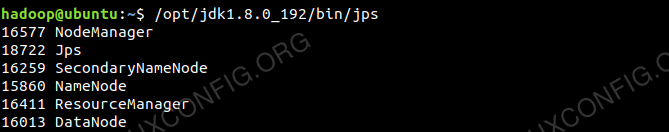

Iniciar el script de inicio del hilo para comenzar el hilo. Para verificar todos los servicios/demonios de Hadoop se inicia con éxito, puede usar el JPS dominio.

/opt/jdk1.8.0_192/bin/jps 20035 Secondarynamenode 19782 Datanode 21671 JPS 20343 Nodemanager 19625 Namenode 20187 ResourceManager  Salida de Hadoop Daemons del comando JPS.

Salida de Hadoop Daemons del comando JPS.

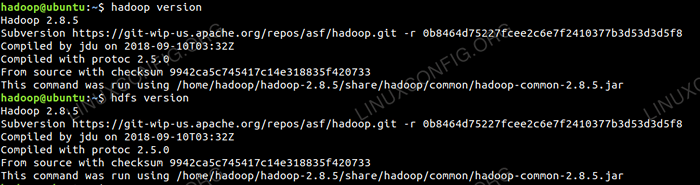

Ahora podemos verificar la versión actual de Hadoop que puede usar el siguiente comando:

Versión de $ Hadoop

o

Versión de $ HDFS

Revise la versión de Hadoop.

Revise la versión de Hadoop.

Interfaz de línea de comandos HDFS

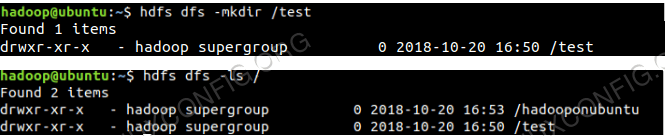

Para acceder a los HDF y crear algunos directorios en la parte superior de DFS, puede usar HDFS CLI.

$ hdfs dfs -mkdir /test $ hdfs dfs -mkdir /hadooponubuntu $ hdfs dfs -ls /

Creación de directorio HDFS usando HDFS CLI.

Creación de directorio HDFS usando HDFS CLI.

Acceda al NameNode y al hilo desde el navegador

Puede acceder a la interfaz de usuario web para el administrador de recursos de Namenode y el hilo a través de cualquiera de los navegadores como Google Chrome/Mozilla Firefox.

Ui web namenode - http: //: 50070

Interfaz de usuario web de NameNode.

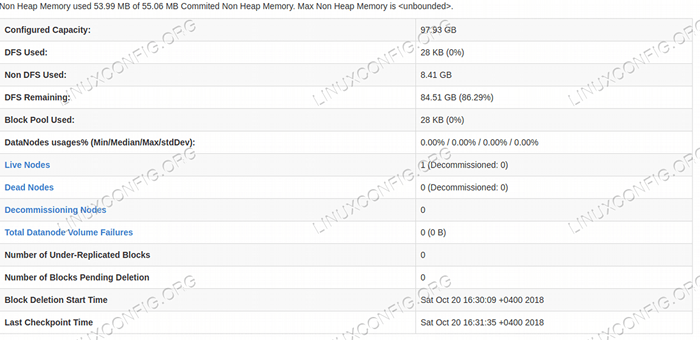

Interfaz de usuario web de NameNode.  Detalles de HDFS desde la interfaz de usuario web de NameNode.

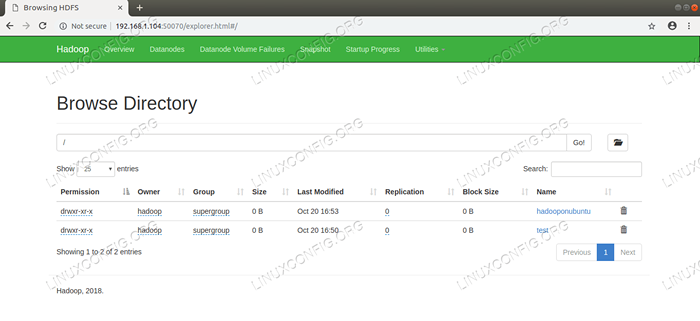

Detalles de HDFS desde la interfaz de usuario web de NameNode.  Navegación del directorio HDFS a través de la interfaz de usuario web de NameNode.

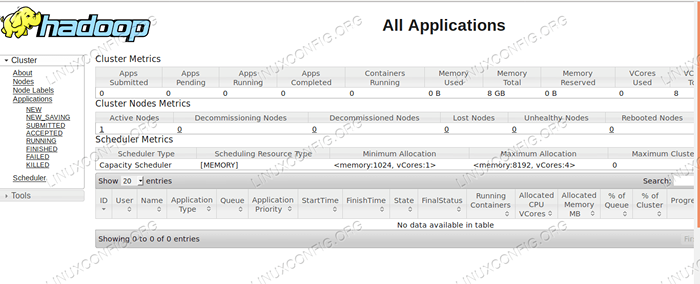

Navegación del directorio HDFS a través de la interfaz de usuario web de NameNode. La interfaz web de Yarn Resource Manager (RM) mostrará todos los trabajos en ejecución en el clúster Hadoop actual.

Ui web administrador de recursos - http: //: 8088

Interfaz de usuario web administrador de recursos.

Interfaz de usuario web administrador de recursos. Conclusión

El mundo está cambiando la forma en que está operando actualmente y los grandes datos están jugando un papel importante en esta fase. Hadoop es un marco que hace que nuestra vida sea fácil mientras trabaja en grandes conjuntos de datos. Hay mejoras en todos los frentes. El futuro es emocionante.

Tutoriales de Linux relacionados:

- Ubuntu 20.04 Hadoop

- Cosas para instalar en Ubuntu 20.04

- Cómo crear un clúster de Kubernetes

- Cómo instalar Kubernetes en Ubuntu 20.04 fossa focal Linux

- Cosas que hacer después de instalar Ubuntu 20.04 fossa focal Linux

- Cómo instalar Kubernetes en Ubuntu 22.04 Jellyfish de Jammy ..

- Cosas para instalar en Ubuntu 22.04

- Cómo trabajar con la API REST de WooCommerce con Python

- Cómo administrar los grupos de Kubernetes con Kubectl

- Una introducción a la automatización, herramientas y técnicas de Linux

- « Cómo instalar Android Studio en Manjaro 18 Linux

- Cómo instalar Google Chrome en Manjaro 18 Linux »