Configuración de RAID Nivel 6 (rayando con paridad distribuida doble) en Linux - Parte 5

- 3917

- 938

- Jaime Delgadillo

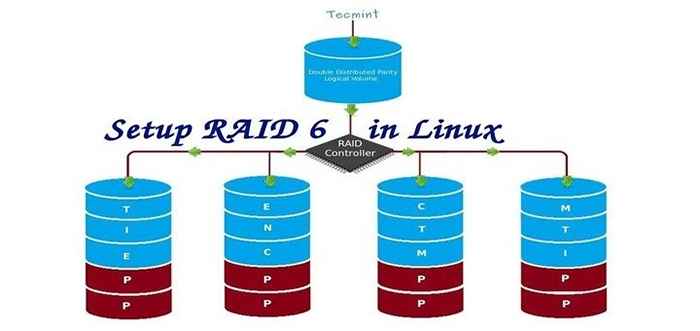

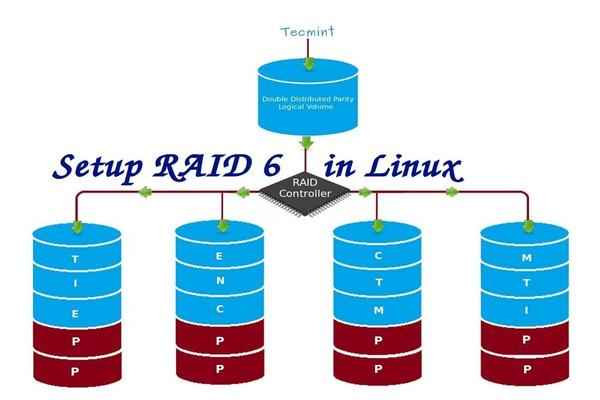

Raid 6 se actualiza la versión de Raid 5, donde tiene dos paridad distribuida que proporciona tolerancia a fallas incluso después de que falla dos unidades. Sistema de misión crítica aún operativa en caso de dos fallas de discos concurrentes. Es igual Raid 5, pero proporciona más robusto, porque usa un disco más para la paridad.

En nuestro artículo anterior, hemos visto paridad distribuida en Raid 5, Pero en este artículo vamos a ver Raid 6 con doble paridad distribuida. No espere un rendimiento adicional que cualquier otro RAID, si es así, también tenemos que instalar un controlador RAID dedicado. Aquí en Raid 6 Incluso si perdemos nuestros 2 discos, podemos recuperar los datos reemplazando una unidad de repuesto y construirlos a partir de la paridad.

Configurar RAID 6 en Linux

Configurar RAID 6 en Linux Para configurar un Raid 6, mínimo 4 Se requieren números de discos o más en un conjunto. Raid 6 tener múltiples discos incluso en algún conjunto, puede tener algunos discos, mientras lee, se lee de todas las unidades, por lo que leer sería más rápido, mientras que la escritura sería pobre porque tiene que rayar sobre múltiples discos.

Ahora, muchos de nosotros llegan a la conclusión, por qué necesitamos usar Raid 6, Cuando no funciona como cualquier otra incursión. Hmm ... aquellos que plantean esta pregunta deben saber que, si necesitan tolerancia de fallas altas, elija Raid 6. En cada entorno superior con alta disponibilidad para la base de datos, utilizan Raid 6 Debido a que la base de datos es la más importante y debe ser segura en cualquier costo, también puede ser útil para los entornos de transmisión de video.

Pros y contras de Raid 6

- El rendimiento es bueno.

- RAID 6 es costoso, ya que requiere que se usen dos unidades independientes para las funciones de paridad.

- Perderá una capacidad de dos discos para usar información de paridad (doble paridad).

- Sin pérdida de datos, incluso después de que falla dos disco. Podemos reconstruir de la paridad después de reemplazar el disco fallido.

- La lectura será mejor que RAID 5, porque se lee desde el disco múltiple, pero la escritura del rendimiento será muy pobre sin controlador de RAID dedicado.

Requisitos

Se requieren un mínimo de 4 números de discos para crear un Raid 6. Si desea agregar más discos, puede, pero debe tener un controlador RAID dedicado. En Software Raid, no obtendremos un mejor rendimiento en RAID 6. Así que necesitamos un controlador de incursión física.

Aquellos que son nuevos en la configuración de RAID, recomendamos pasar por los artículos de RAID a continuación.

- Conceptos básicos de RAID en Linux - Parte 1

- Creación de software RAID 0 (Stripe) en Linux - Parte 2

- Configuración de RAID 1 (reflejo) en Linux - Parte 3

Mi configuración de servidor

Sistema operativo: Centos 6.5 Dirección IP final: 192.168.0.228 Nombre de host: RD6.tecmintlocal.com disco 1 [20GB]: /dev /sdb disco 2 [20gb]: /dev /sdc disco 3 [20GB]: /dev /sdd disco 4 [20GB]: /dev /sde

Este artículo es un Parte 5 De una serie RAID de 9 tutoriales, aquí vamos a ver cómo podemos crear y configurar el software Raid 6 o rayando con paridad distribuida doble en sistemas o servidores Linux utilizando cuatro discos de 20 GB llamados /dev /sdb, /dev /sdc, /dev /sdd y /dev /sde.

Paso 1: Instalación de la herramienta MDADM y examina las unidades

1. Si estás siguiendo nuestros dos últimos artículos de RAID (Parte 2 y PArt 3), donde ya hemos mostrado cómo instalar 'mada' herramienta. Si eres nuevo en este artículo, déjame explicarte eso 'mada'Es una herramienta para crear y administrar RAID en los sistemas Linux, instalar la herramienta utilizando el comando siguiente de acuerdo con su distribución de Linux.

# yum install mdadm [en sistemas redhat] # apt-get install mDadm [en sistemas de debain]

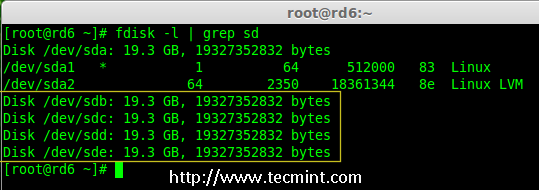

2. Después de instalar la herramienta, ahora es el momento de verificar las cuatro unidades adjuntas que vamos a usar para la creación de RAID utilizando lo siguiente 'fdisk' dominio.

# fdisk -l | Grep SD

Verifique los discos en Linux

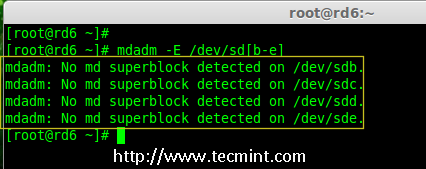

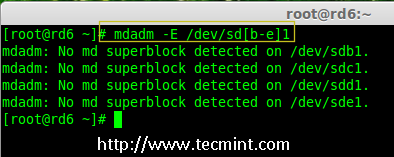

Verifique los discos en Linux 3. Antes de crear un impulso de redada, siempre examine nuestras unidades de disco si hay alguna incursión ya creada en los discos.

# mdadm -e /dev /sd [b -e] # mdadm --examine /dev /sdb /dev /sdc /dev /sdd /dev /sde

Verifique el RAID en el disco

Verifique el RAID en el disco Nota: En la imagen de arriba representa que no hay ningún súper bloque detectado o no se define una redada en cuatro unidades de disco. Podemos avanzar más para comenzar a crear RAID 6.

Paso 2: Partitionamiento de la unidad para RAID 6

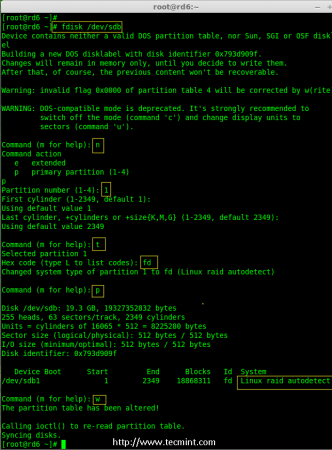

4. Ahora cree particiones para RAID en '/dev/sdb','/dev/sdc','/dev/sdd' y '/dev/sde'Con la ayuda de seguir fdisk dominio. Aquí, mostraremos cómo crear partición en SDB conducir y más tarde los mismos pasos a seguir para el resto de las unidades.

Partition Crear /dev /sdb

# fdisk /dev /sdb

Siga las instrucciones como se muestra a continuación para crear partición.

- Prensa 'norte'Para crear una nueva partición.

- Entonces escoge 'PAG'Para la partición primaria.

- A continuación, elija el número de partición como 1.

- Defina el valor predeterminado simplemente presionando dos veces Ingresar llave.

- Siguiente prensa 'PAG'para imprimir la partición definida.

- Prensa 'L'Para enumerar todos los tipos disponibles.

- Tipo 'T'elegir las particiones.

- Elegir 'fd'Para Linux RAID Auto y presione Entrar para aplicar.

- Luego usa de nuevo 'PAG'Para imprimir los cambios lo que hemos realizado.

- Usar 'w'Para escribir los cambios.

Partition Crear /dev /sdb

Partition Crear /dev /sdb Partition Crear /dev /sdb

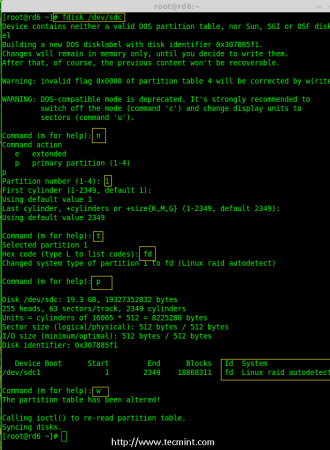

# fdisk /dev /sdc

Crear /dev /sdc particion

Crear /dev /sdc particion Partition Crear /dev /sdd

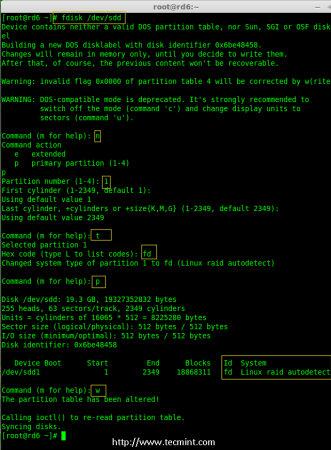

# fdisk /dev /sdd

Partition Crear /dev /sdd

Partition Crear /dev /sdd Partition Crear /dev /sde

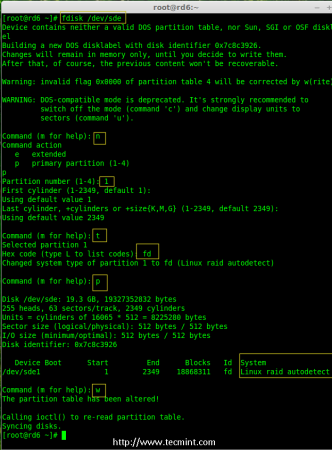

# fdisk /dev /sde

Partition Crear /dev /sde

Partition Crear /dev /sde 5. Después de crear particiones, siempre es un buen hábito examinar las unidades de super-bloques. Si no existe superploqueos, podemos ir de cabeza para crear una nueva configuración de RAID.

# mDadm -e /dev /sd [b -e] 1 o # mdadm --examine /dev /sdb1 /dev /sdc1 /dev /sdd1 /dev /sde1

Consulte RAID en nuevas particiones

Consulte RAID en nuevas particiones Paso 3: Creación del dispositivo MD (RAID)

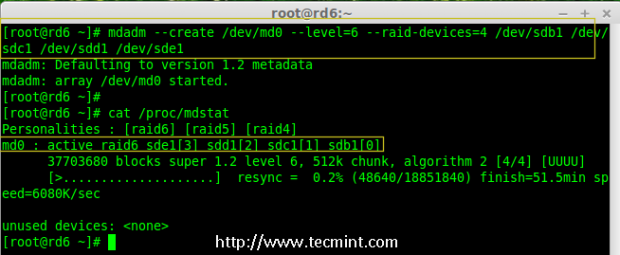

6. Ahora es el momento de crear un dispositivo RAID 'MD0' (i.mi. /dev/md0) y aplique el nivel de RAID en todas las particiones recién creadas y confirme el RAID utilizando los siguientes comandos.

# mdadm --create /dev /md0 --level = 6 -Raid-Devices = 4 /dev /sdb1 /dev /sdc1 /dev /sdd1 /dev /sde1 # cat /proc /mdstat

Crear dispositivo RAID 6

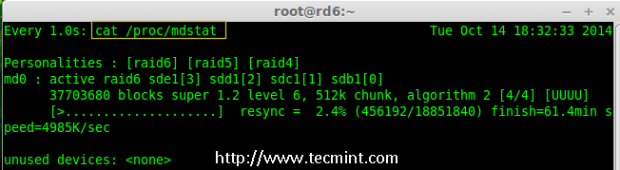

Crear dispositivo RAID 6 7. También puede verificar el proceso actual de RAID utilizando mirar Comando como se muestra en la pantalla Agarra a continuación.

# watch -n1 cat /proc /mdstat

Verifique el proceso RAID 6

Verifique el proceso RAID 6 8. Verifique los dispositivos RAID usando el siguiente comando.

# mdadm -e /dev /sd [b -e] 1

Nota:: El comando anterior mostrará la información de los cuatro discos, que es bastante largo, por lo que no es posible publicar la salida o la captura de pantalla aquí.

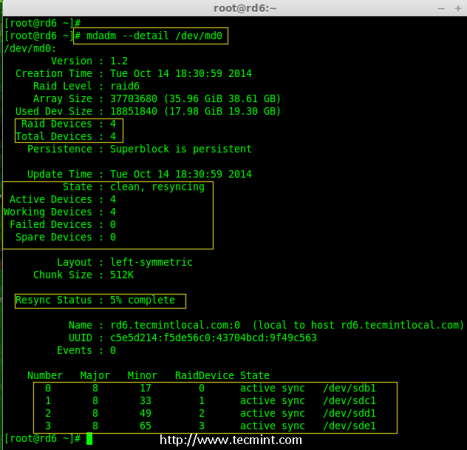

9. A continuación, verifique la matriz RAID para confirmar que se inicia la re-sincronización.

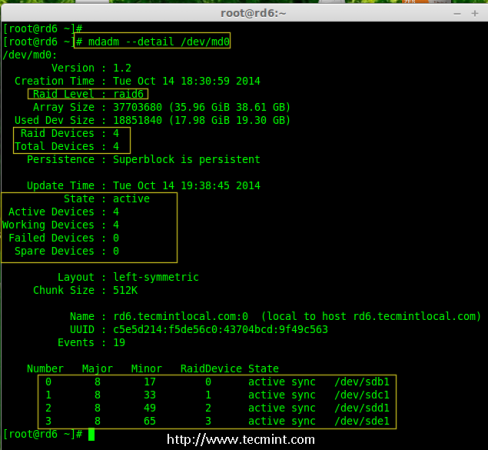

# MDADM --DETAIL /DEV /MD0

Verifique la matriz RAID 6

Verifique la matriz RAID 6 Paso 4: Creación del sistema de archivos en el dispositivo RAID

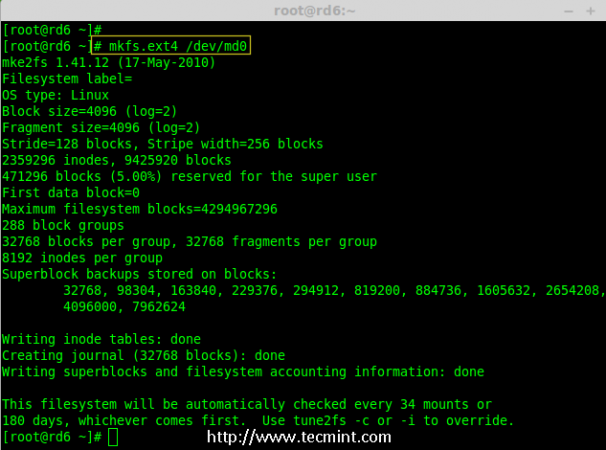

10. Cree un sistema de archivos usando ext4 para '/dev/md0'Y montarlo debajo /Mnt/Raid6. Aquí hemos usado Ext4, pero puede usar cualquier tipo de sistema de archivos según su elección.

# MKFS.ext4 /dev /md0

Crear sistema de archivos en RAID 6

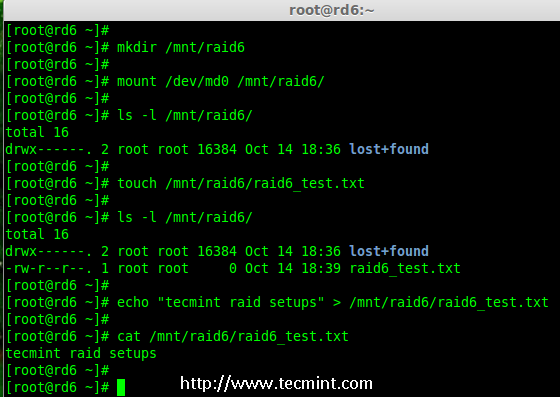

Crear sistema de archivos en RAID 6 11. Monte el sistema de archivos creado en /Mnt/Raid6 y verifique los archivos en el punto de montaje, podemos ver el directorio de Lost+encontrado.

# mkdir/mnt/raid6 # monte/dev/md0/mnt/raid6/ # ls -l/mnt/raid6/

12. Cree algunos archivos en el punto de montaje y agregue algún texto en cualquiera de los archivos para verificar el contenido.

# touch/mnt/raid6/raid6_test.txt # ls -l/mnt/raid6/ # echo "Configuras de ataques de tecmint">/mnt/raid6/raid6_test.txt # cat/mnt/raid6/raid6_test.TXT

Verificar contenido de RAID

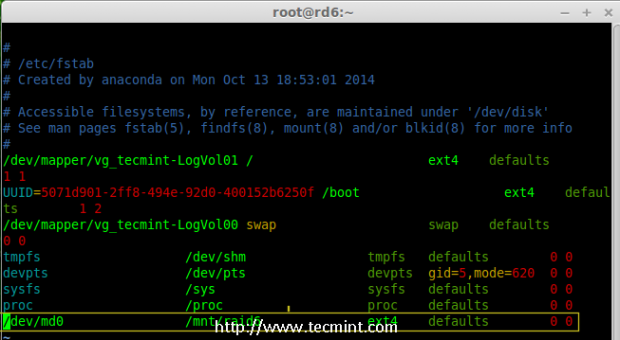

Verificar contenido de RAID 13. Agregar una entrada en /etc/fstab Para montar automáticamente el dispositivo al inicio del sistema y agregar la entrada a continuación, el punto de montaje puede diferir de acuerdo con su entorno.

# vim /etc /fstab /dev /md0 /mnt /raid6 ext4 predeterminados 0 0 0

Automount RAID 6 Dispositivo

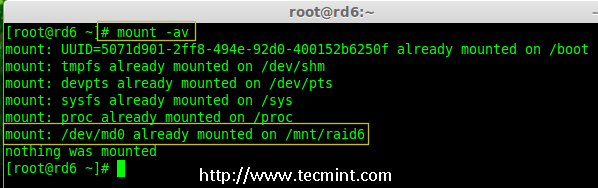

Automount RAID 6 Dispositivo 14. A continuación, ejecutar 'Monte -A'Comando para verificar si hay algún error en la entrada FSTAB.

# Monte -av

Verificar RAID AUTOMOUNT

Verificar RAID AUTOMOUNT Paso 5: Guardar la configuración RAID 6

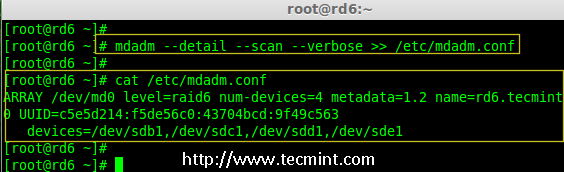

15. Tenga en cuenta que, por defecto, RAID no tiene un archivo de configuración. Tenemos que guardarlo utilizando manualmente el siguiente comando y luego verificar el estado del dispositivo '/dev/md0'.

# mdadm --detail --scan --verbose >> /etc /mdadm.conf # mdadm --detail /dev /md0

Guardar la configuración RAID 6

Guardar la configuración RAID 6  Verifique el estado RAID 6

Verifique el estado RAID 6 Paso 6: Agregar unidades de repuesto

dieciséis. Ahora tiene 4 discos y hay dos información de paridad disponibles. En algunos casos, si cualquiera de los disco falla, podemos obtener los datos, porque hay una doble paridad en RAID 6.

Puede ser si el segundo disco falla, podemos agregar uno nuevo antes de perder el tercer disco. Es posible agregar un disco de repuesto mientras crea nuestro conjunto de redadas, pero no he definido la unidad de repuesto mientras crea nuestro conjunto de incursiones. Pero, podemos agregar una unidad de repuesto después de cualquier falla de la unidad o mientras creamos el conjunto de redadas. Ahora ya hemos creado el conjunto de incursiones ahora déjame agregar un disco de repuesto para la demostración.

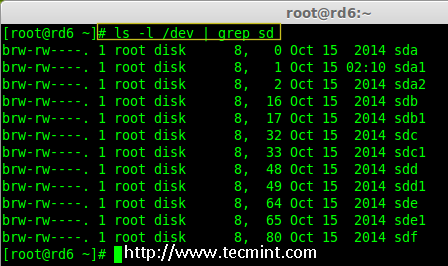

Para el propósito de demostración, he colgado un nuevo disco HDD (yo.mi. /dev/sdf), verifiquemos el disco adjunto.

# ls -l / dev / | Grep SD

Revise el nuevo disco

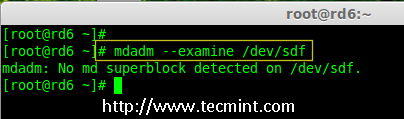

Revise el nuevo disco 17. Ahora, confirme nuevamente, el nuevo disco adjunto para cualquier RAID ya está configurado o no utilizando el mismo mada dominio.

# mdadm --examine /dev /sdf

Consulte RAID en un nuevo disco

Consulte RAID en un nuevo disco Nota: Como de costumbre, como hemos creado particiones para cuatro discos anteriores, de manera similar tenemos que crear una nueva partición en el nuevo disco enchufado usando fdisk dominio.

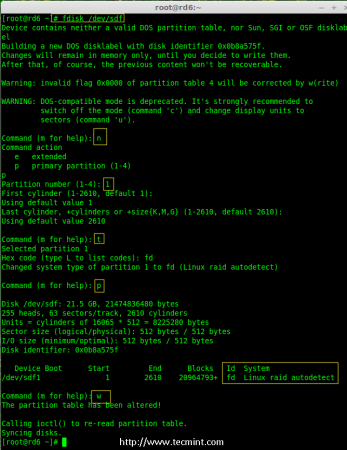

# fdisk /dev /sdf

Partition Crear /dev /sdf

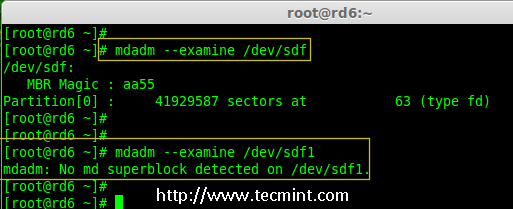

Partition Crear /dev /sdf 18. Nuevamente después de crear una nueva partición en /dev/sdf, Confirme la redada en la partición, incluya el disco de repuesto al /dev/md0 dispositivo RAID y verificar el dispositivo agregado.

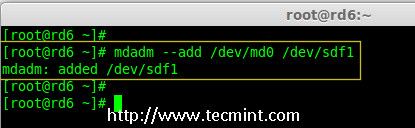

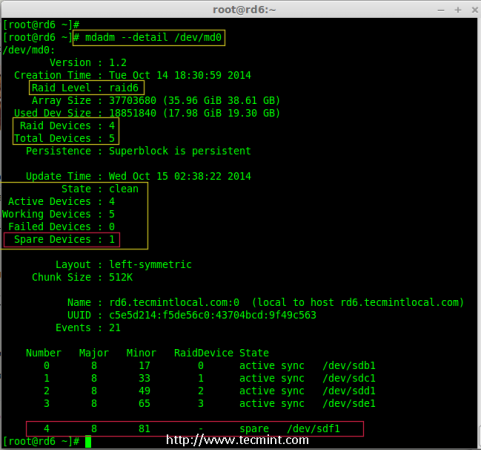

# mdadm --examine /dev /sdf # mdadm --examine /dev /sdf1 # mdadm --add /dev /md0 /dev /sdf1 # mdadm --detail /dev /md0

Verificar RAID en la partición SDF

Verificar RAID en la partición SDF  Agregar partición SDF a RAID

Agregar partición SDF a RAID  Verificar los detalles de la partición SDF

Verificar los detalles de la partición SDF Paso 7: Verifique la tolerancia de fallas RAID 6

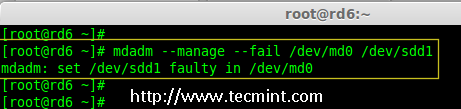

19. Ahora, verifiquemos si la unidad de repuesto funciona automáticamente, si alguien del disco falla en nuestra matriz. Para las pruebas, personalmente he marcado una de las transmisiones que fallan.

Aquí, vamos a marcar /dev/sdd1 Como impulso fallido.

# MDADM --Manage --Fail /Dev /MD0 /Dev /SDD1

Verifique la tolerancia de fallas RAID 6

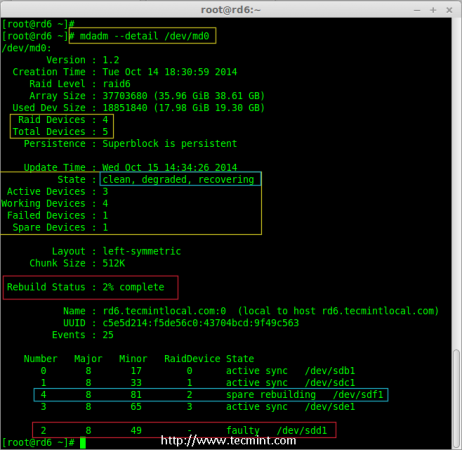

Verifique la tolerancia de fallas RAID 6 20. Permítanme obtener los detalles de RAID Set ahora y verificar si nuestro repuesto comenzó a sincronizar.

# MDADM --DETAIL /DEV /MD0

Verifique la sincronización de Auto Raid

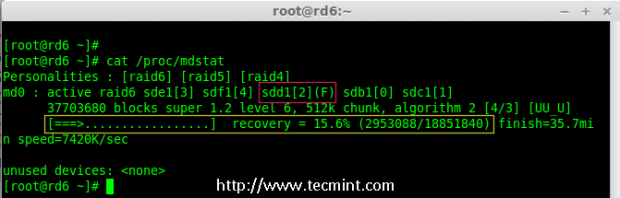

Verifique la sincronización de Auto Raid Viva! Aquí, podemos ver que el repuesto se activó y comenzó al proceso de reconstrucción. En la parte inferior podemos ver la unidad defectuosa /dev/sdd1 Listado como defectuoso. Podemos monitorear el proceso de compilación utilizando el siguiente comando.

# Cat /Proc /Mdstat

RAID 6 sincronización automática

RAID 6 sincronización automática Conclusión:

Aquí, hemos visto cómo configurar Raid 6 Usando cuatro discos. Este nivel de incursión es uno de los costosos configuración con alta redundancia. Veremos cómo configurar un Raid anidada 10 y mucho más en los próximos artículos. Hasta entonces, mantente conectado con Tecmenta.

- « Cómo actualizar desde Ubuntu 16.10 a Ubuntu 17.04

- 10 razones por las que debe usar el editor de texto VI/VIM en Linux »