Cómo instalar Apache Kafka en Ubuntu 20.04

- 2052

- 202

- Berta Solano

Apache Kafka es una plataforma de transmisión de eventos distribuida de código abierto desarrollada por Apache Software Foundation. Esto está escrito en lenguajes de programación de Scala y Java. Puede instalar kafka en cualquier plataforma que admite Java.

Este tutorial describió su tutorial paso a paso para instalar Apache Kafka en Ubuntu 20.04 Sistema LTS Linux. También aprenderá a crear temas en kafka y ejecutar nodos de productores y consumidores.

Requisitos previos

Debe tener acceso de cuenta privilegiado de sudo al Ubuntu 20.04 Sistema Linux.

Paso 1 - Instalación de Java

Apache Kafka se puede ejecutar en todas las plataformas compatibles con Java. Para configurar Kafka en el sistema Ubuntu, primero debe instalar Java. Como sabemos, Oracle Java ahora está disponible comercialmente, por lo que estamos utilizando su versión de código abierto OpenJDK.

Ejecute el siguiente comando a continuación para instalar OpenJDK en su sistema desde el PPA oficial.

sudo apt actualización sudo apt instalación predeterminado-jdk

Verifique la versión actual de Java activa.

Java -Versión OpenJDK versión "11.0.9.1 "2020-11-04 OpenJDK Runtime Environment (Build 11.0.9.1+1-Ubuntu-0ubuntu1.20.04) OpenJDK VM de 64 bits (compilación 11.0.9.1+1-Ubuntu-0ubuntu1.20.04, modo mixto, compartir) Paso 2 - Descargue el último Apache Kafka

Descargue los archivos binarios Apache Kafka desde su sitio web de descarga oficial. También puede seleccionar cualquier espejo cercano para descargar.

wget https: // dlcdn.apache.org/kafka/3.2.0/kafka_2.13-3.2.0.tgz Luego extraiga el archivo de archivo

tar xzf kafka_2.13-3.2.0.tgzsudo mv kafka_2.13-3.2.0/usr/local/kafka

Paso 3 - Creación de archivos de la unidad Systemd

Ahora, debe crear archivos de la unidad Systemd para los servicios Zookeeper y Kafka. Que lo ayudará a comenzar/detener el servicio Kafka de una manera fácil.

Primero, cree un archivo de la unidad Systemd para ZOOKEEPER:

vim/etc/systemd/system/zookeeper.servicio

Y agregue el siguiente contenido:

[Unidad] Descripción = Documentación del servidor ZOOKEEPER Apache = http: // Zookeepers.apache.org requiere = red.Target Remote-FS.Target After = Network.Target Remote-FS.Target [Service] Type = Simple Execstart =/usr/local/kafka/bin/Zookeeper-server-start.SH/USR/LOCAL/KAFKA/CONFIG/ZOOKEEPER.Properties Execstop =/usr/local/kafka/bin/Zookeeper-server-stop.sh reinsart = on-abnormal [install] Wantedby = Multi-user.objetivo

Guarde el archivo y cierre.

A continuación, para crear un archivo de la unidad Systemd para el servicio Kafka:

vim/etc/systemd/system/kafka.servicio

Agregue el contenido a continuación. Asegúrese de establecer el correcto Java_home ruta según el Java instalado en su sistema.

[Unidad] Descripción = Documentación del servidor Apache Kafka = http: // kafka.apache.organización/documentación.html requiere = ZOOKEEPER.Servicio [Servicio] Type = Simple Environment = "java_home =/usr/lib/jvm/java-1.11.0-openjdk-amd64 "execstart =/usr/local/kafka/bin/kafka-server-start.sh/usr/local/kafka/config/servidor.Properties Execstop =/usr/local/kafka/bin/kafka-server-stop.sh [install] WantedBy = Multiuser.objetivo

Guarde el archivo y cierre.

Recargar el Systemd Daemon para aplicar nuevos cambios.

SystemCTL-Daemon-Re-Reloting

Paso 4 - Inicie Kafka y Servicio de Zookeeper

Primero, debe iniciar el servicio Zookeeper y luego comenzar Kafka. Use el comando SystemCTL para iniciar una instancia de Zookeeper de un solo nodo.

sudo systemctl iniciar zookeeper

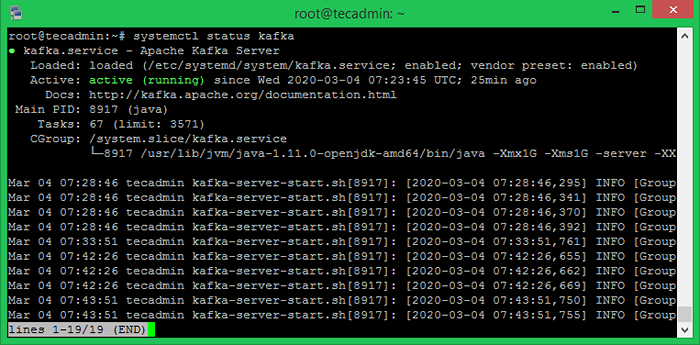

Ahora inicie el servidor Kafka y vea el estado de ejecución:

SUDO SYSTEMCTL Start Kafka sudo SystemCtl Status Kafka

Todo listo. La instalación de Kafka se ha completado con éxito. La parte de este tutorial lo ayudará a trabajar con el servidor Kafka.

Paso 5 - Crea un tema en Kafka

Kafka proporciona múltiples scripts de carcasa preconstruidos para trabajar en él. Primero, cree un tema llamado "TestTopic" con una sola partición con una sola réplica:

CD/USR/Local/Kafka Bin/Kafka-Topics.SH --Create --Bootstrap-server localhost: 9092--Repplication-Factor 1-Partitions 1-topictopic topictopic Topictopic.

El factor de replicación describe cuántas copias de datos se crearán. Mientras estamos ejecutando con una sola instancia, mantenga este valor 1.

Establezca las opciones de partición como la cantidad de corredores que desea que sus datos se dividan entre. Mientras estamos ejecutando con un solo corredor, mantenga este valor 1.

Puede crear múltiples temas ejecutando el mismo comando que el anterior. Después de eso, puede ver los temas creados en Kafka mediante el comando Ejecutar a continuación:

bin/kafka-topics.sh --list --bootstrap-server localhost: 9092 [salida] testtopic

Alternativamente, en lugar de crear temas manualmente, también puede configurar a sus corredores para crear temas automáticos cuando se publica un tema inexistente para.

Paso 6: enviar y recibir mensajes en Kafka

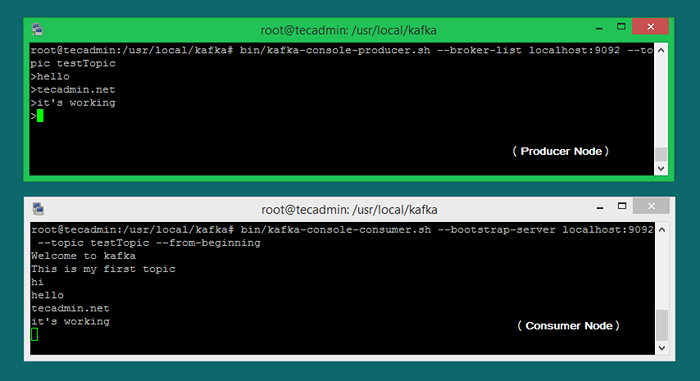

El "productor" es el proceso responsable de poner datos en nuestro kafka. El kafka viene con un cliente de línea de comandos que tomará la entrada de un archivo o de la entrada estándar y la enviará como mensajes al clúster Kafka. El kafka predeterminado envía cada línea como un mensaje separado.

Ejecutemos el productor y luego escribamos algunos mensajes en la consola para enviar al servidor.

productor de comodín de bin/kafka.SH --Broker-List Localhost: 9092-Topic Testtopic> Bienvenido a Kafka> Este es mi primer tema>

Puede salir de este comando o mantener este terminal en ejecución para pruebas adicionales. Ahora abra un nuevo terminal al proceso de consumidor de Kafka en el siguiente paso.

Paso 7 - Uso de Kafka Consumer

Kafka también tiene un consumidor de línea de comandos para leer los datos del clúster Kafka y mostrar mensajes a la salida estándar.

contenedor.sh --bootstrap-server localhost: 9092--topic testtopic-desde el beginimiento Bienvenido a Kafka Este es mi primer tema

Ahora, si todavía ha ejecutado el productor de Kafka (paso #6) en otra terminal. Simplemente escriba un texto en esa terminal del productor. inmediatamente será visible en la terminal del consumidor. Consulte la siguiente captura de pantalla del productor y consumidor de Kafka para trabajar:

Conclusión

Este tutorial le ayudó a instalar y configurar el servicio Apache Kafka en un sistema Ubuntu. Además, aprendió a crear un nuevo tema en el servidor Kafka y ejecutar una producción de muestra y un proceso de consumidor con Apache Kafka.